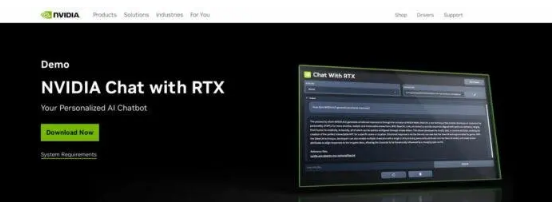

NVIDIA最近推出了一款突破性的 AI 聊天机器人 Chat with RTX。它设计为在配备 NVIDIA RTX 30 或 40 系列 GPU 的 Windows PC 上本地运行。这种创新工具允许用户使用他们的内容个性化聊天机器人。它将敏感数据保留在设备上,并避免需要基于云的服务。“Chat with RTX”聊天机器人被设计为本地化系统,用户无需访问互联网即可使用。所有具有至少 8 GB 视频内存的 GeForce RTX 30 和 40 GPU 都支持该应用程序。

Chat with RTX 支持多种文件格式,包括文本、pdf、doc/docx 和 XML。只需将应用程序指向包含文件的文件夹,它就会在几秒钟内将它们加载到库中。此外,用户还可以提供 YouTube 播放列表的 URL,应用程序将加载播放列表中视频的文字记录。这允许用户查询他们所涵盖的内容。

从官方的描述来看,用户可以通过不同的查询来像使用ChatGPT一样使用Chat With RTX 。然而, 生成的结果将完全基于特定的数据集。这似乎更适合生成摘要、快速搜索文档等操作。

拥有支持 TensorRT-LLM 的 RTX GPU 意味着用户将在本地处理所有数据和项目。因此,用户无需将数据保存在云端。这将节省时间并提供更准确的结果。 Nvidia表示,TensorRT-LLM v0.6.0将性能提升5倍,并将于本月晚些时候推出。此外,它将支持其他法学硕士,例如 Mistral 7B 和 Nemotron 3 8B。

新传媒网

新传媒网